Motivation

采用layer-wise relevance propagation (LRP)来计算展现NMT系统的内部组织

Methods

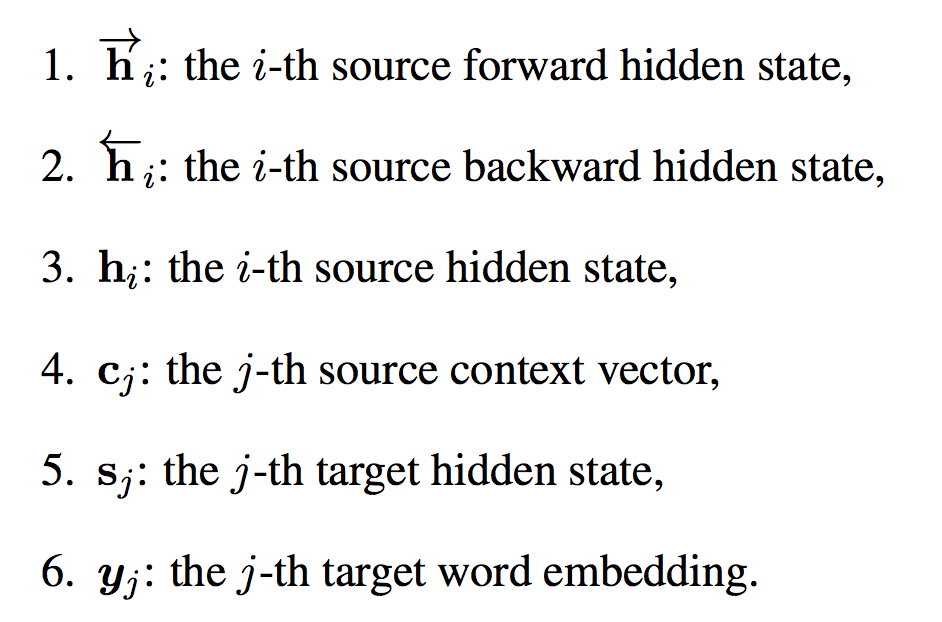

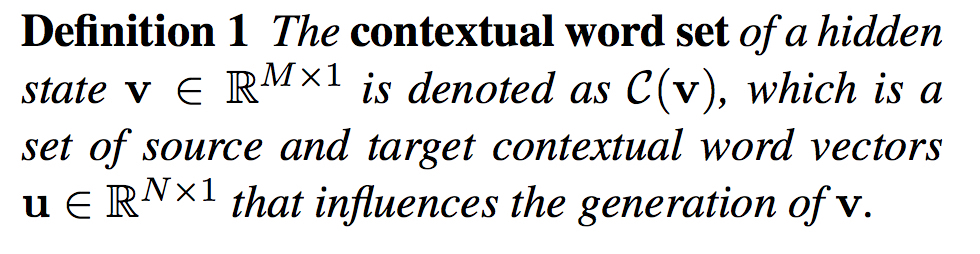

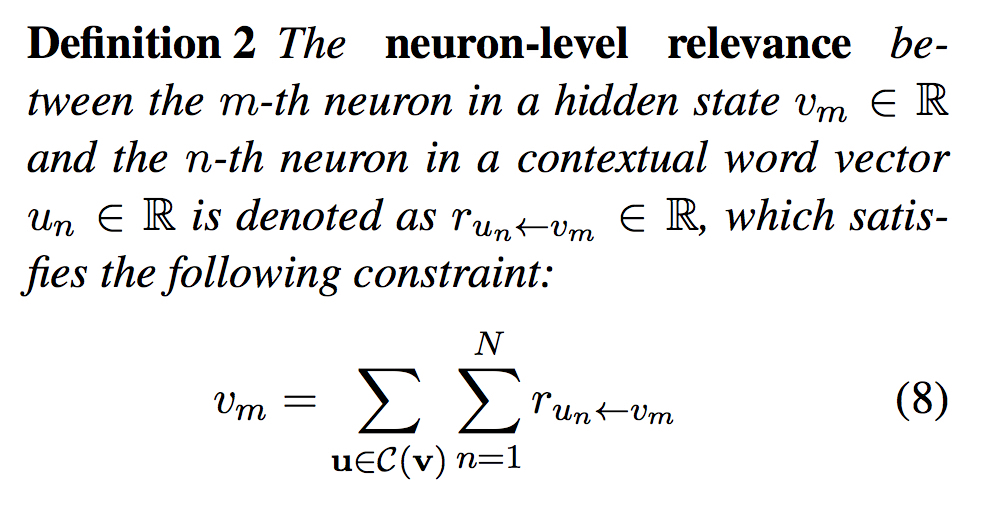

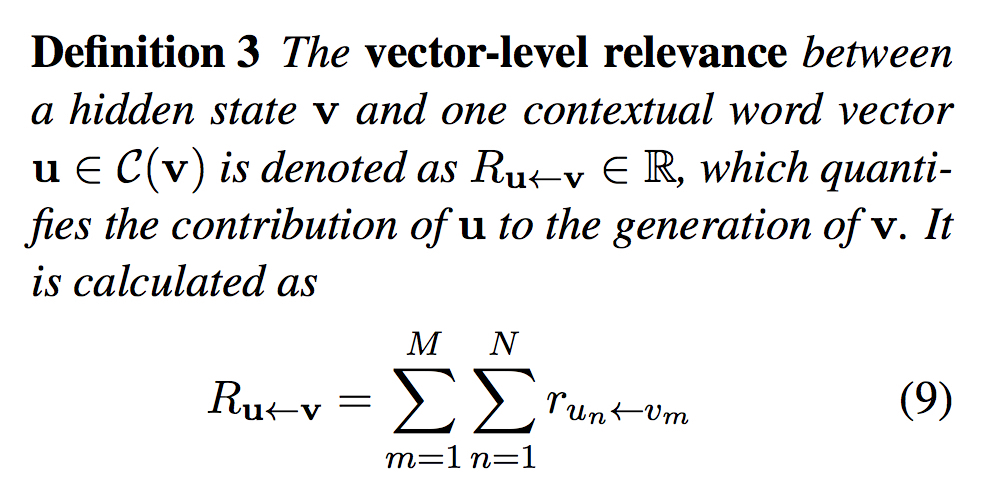

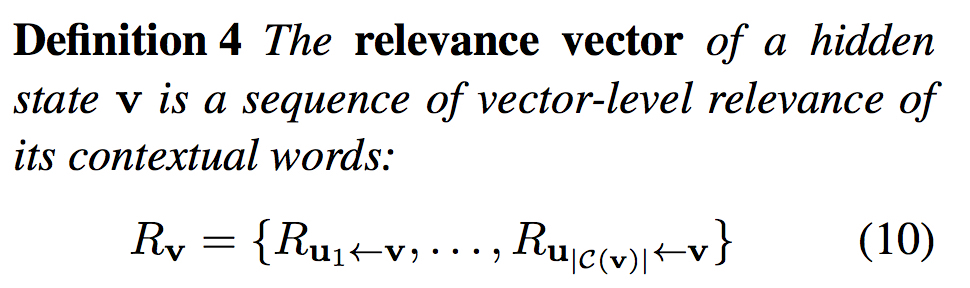

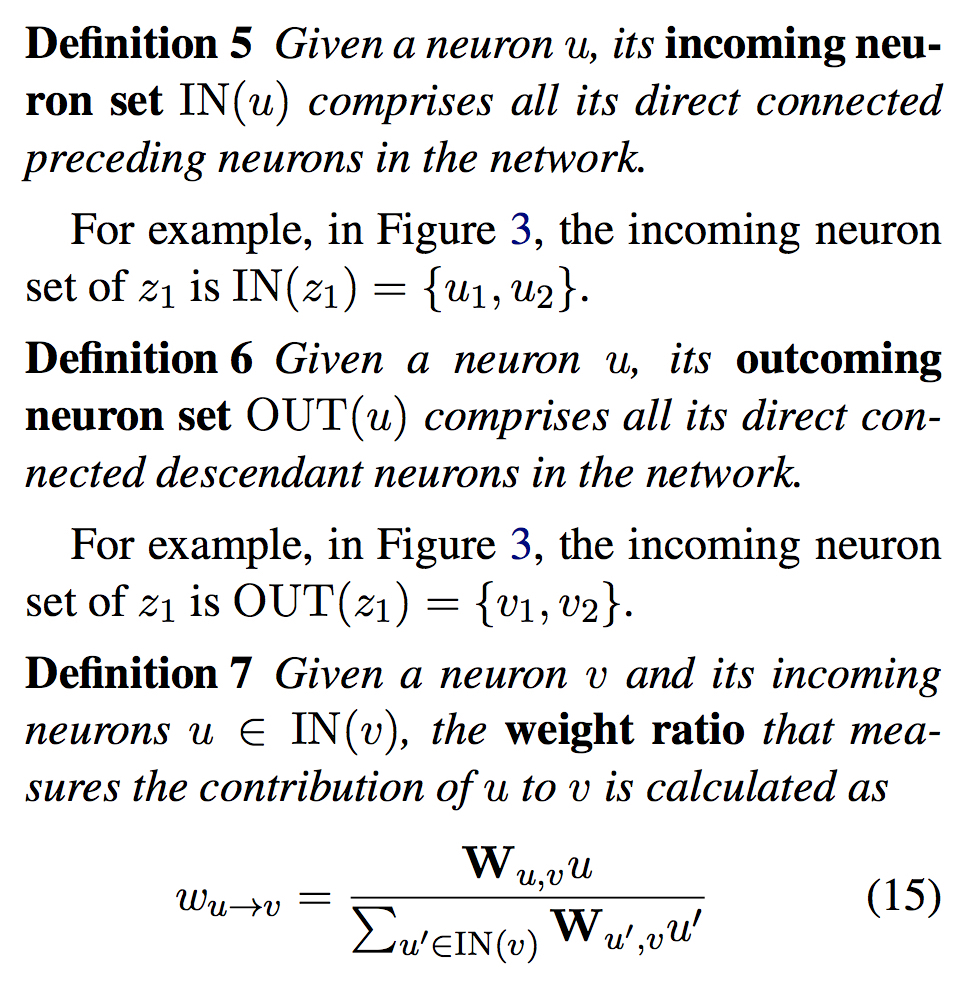

定义

着重关注源端和目标端对几种内部状态的贡献:

为了更好的形式化,作出如下定义:

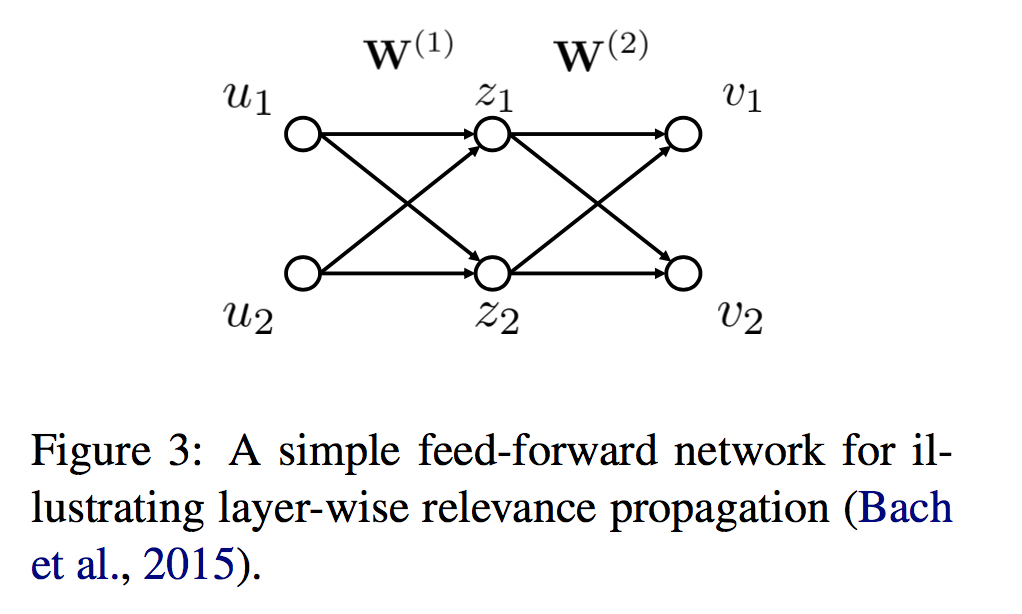

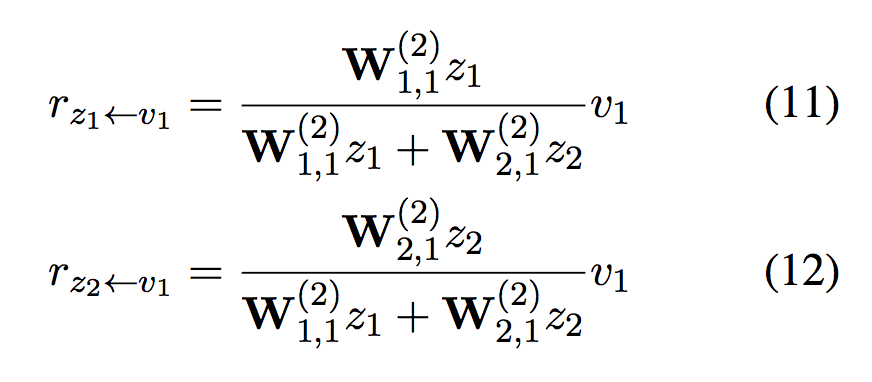

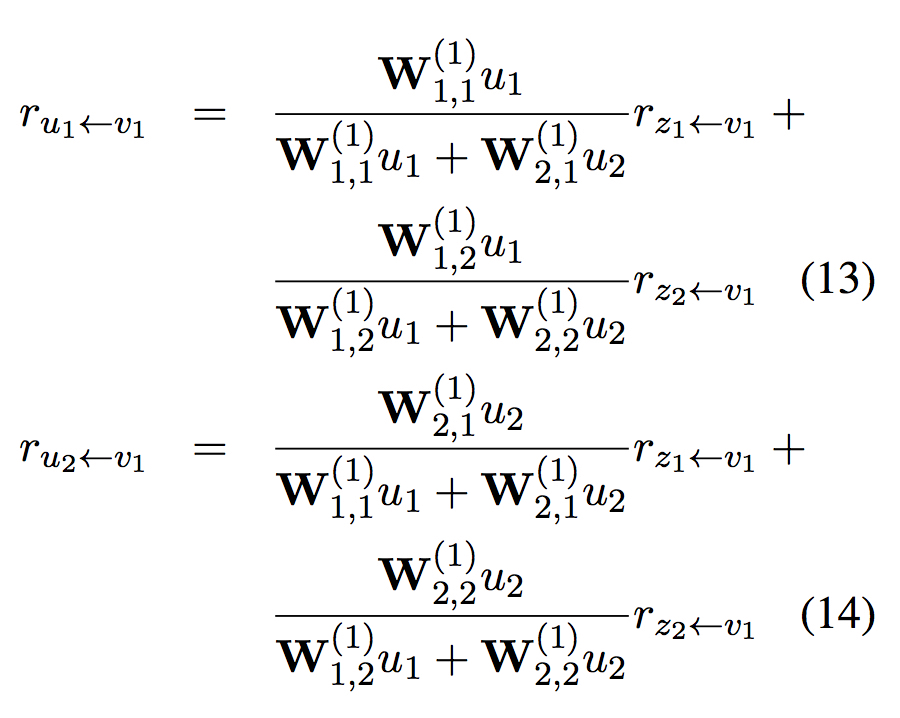

LRP

以上图为例,relevance传递如下:

一些新的定义

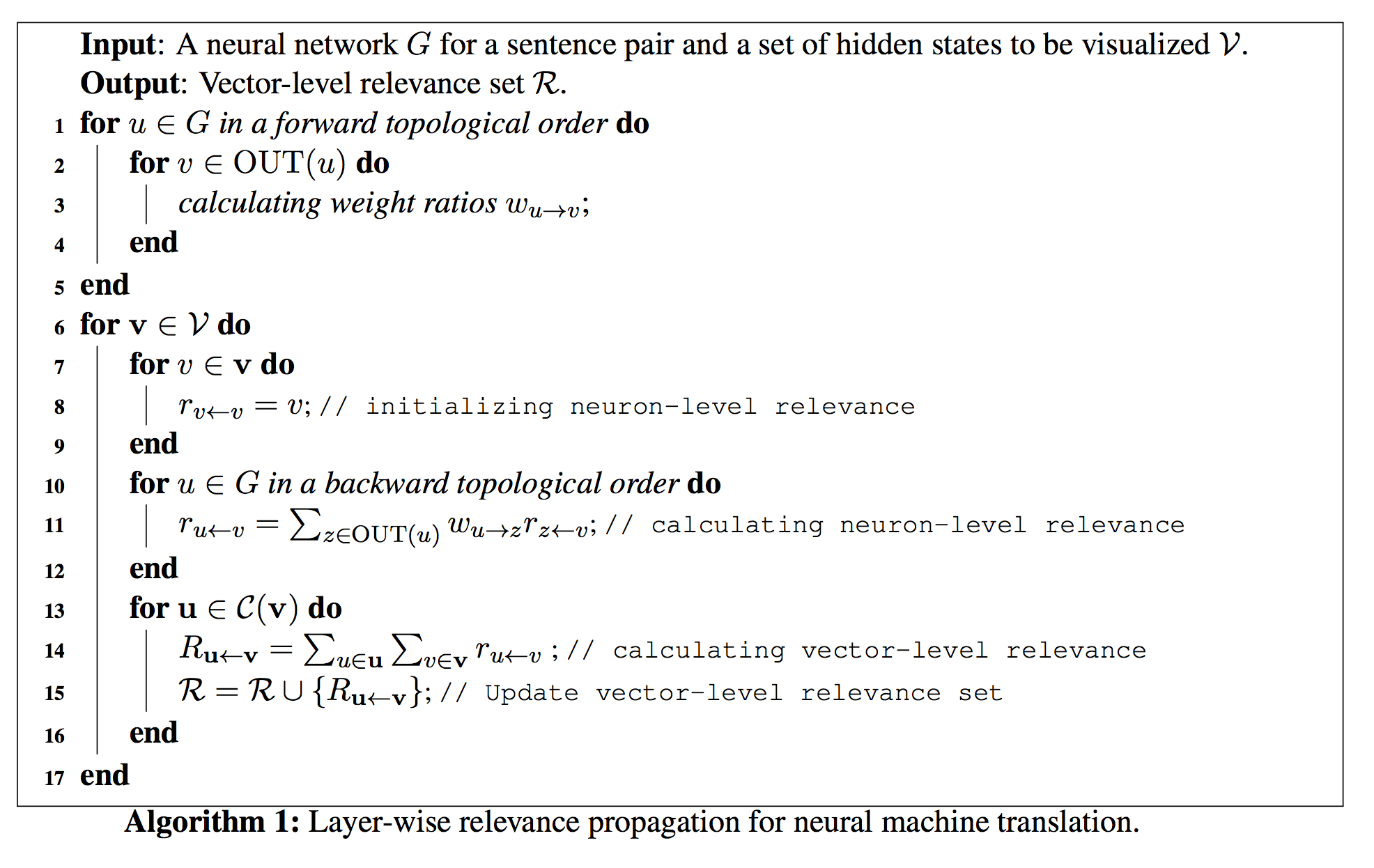

Algorithm

应用LRP到NMT系统中,算法如下

算法复杂度 $O(|G|\times{|V|}\times{O_{max}})$,其中$O_{max}$是中间点的最大出度

Experiments

实验说明了这种LRP的可视化方法可以用来做各种性质分析,如翻译错误原因分析等,比简单的attention更能解释神经网络

根据可视化结果得到的主要结论:

仅仅依赖Attention机制不足以充分解释目标词语的生成

contextual words在不同层的relevance可能有显著区别

目标端的上下文对目标词生成同样有重要影响

过早产生EOS会引起诸如漏译、无关译和短句译等问题